Antropomorfizácia, odvodená z gréckych slov anthrópos (človek) a morfé (tvar), je pripisovanie ľudských vlastností, emócií a správania neživým predmetom, zvieratám alebo abstraktným konceptom. Prejavuje sa v rôznych aspektoch kultúry, od umenia a literatúry cez vedu až po každodenný jazyk a myslenie. Tomuto fenoménu sa nevyhla ani oblasť umelej inteligencie (AI).

Antropomorfné umelé inteligentné systémy, napríklad v podobe robotov, ktoré sa vymkli ľudskej kontrole, sú už celé desaťročia vďačnou a vábivou témou sci-fi literatúry, počítačových hier a kinematografie. Od neúprosných terminátorov cez všemocné umelé mozgy až po vnímavé virtuálne spoločníčky a partnerky hlavných hrdinov sme v popkultúre zaplavení obrazmi AI s humanoidným telom či ľudskými vlastnosťami.

Skúmanie hraníc

S príchodom čoraz výkonnejších systémov AI sa antropomorfizácia v umelej inteligencii prejavuje čoraz komplexnejším spôsobom. Umelá inteligencia už nie je okrajovou vednou disciplínou a stáva sa významným a takmer všadeprítomným artefaktom našej spoločnosti, čím prináša aj vážne spoločenské a etické otázky. A hoci nie je otázka ovládnutia či vyhubenia ľudstva umelou inteligenciou aktuálna, patrí antropomorfizácia umelých systémov medzi jednu z najdôležitejších tém etiky AI.

Antropomorfizácia AI prebieha nielen na úrovni zavádzajúceho pripisovania ľudských vlastností ako vedomie, úmysel či emócie strojom. Odzrkadľuje sa aj v rôznych aspektoch dizajnu, vývoja a interakcie so systémami AI, čím opätovne otvára otázky o hraniciach vzťahu medzi človekom a strojom. Nepoznanie hraníc toho, čím systémy AI sú a čo dokážu, môže ruka v ruke s ich antropomorfizovaním viesť k neželaným dôsledkom.

Obavy z poľudštenia

Vlnu údivu, ale aj istej nevôle vyvolalo prezentovanie humanoidného robota s menom Sofia vyvinutého spoločnosťou Hanson Robotics v roku 2015. Stal sa známym vďaka svojej schopnosti simulovať porozumenie reči a prejavovať ľudské emócie. Robot Sofia dokázal na tú dobu celkom uveriteľne reagovať na otázky a podnety z okolia v reálnom čase. Rozpoznával tváre a emócie, viedol jednoduchú konverzáciu a dokázal aj kresliť. Jeho tvorcovia ho prezentovali na významných podujatiach po celom svete a stal sa predmetom rozsiahleho záujmu médií. Tiež ho použili v rôznych výskumných projektoch zameraných na interakciu človeka s robotom.

Kontroverzný moment nastal v roku 2017, keď Saudská Arábia pripísala Sofii status štátneho občianstva. Niektorí experti sa obávali, že by tento čin mohol viesť k tomu, že ľudia začnú vnímať roboty ešte viac ako ľudské bytosti a budú sa k nim správať, akoby nimi naozaj boli. Iní odborníci prejavili obavy, že podobné roboty založené na AI by sa mohli použiť na manipuláciu s ľuďmi alebo na ich emocionálne zneužívanie.

Predchodca chatbotov

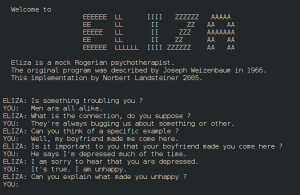

Sofia pritom nie je prvý systém s umelou inteligenciou, pri ktorom bolo možné pozorovať tendenciu nás ľudí antropomorfizovať jeho prejavy. Už v polovici 60. rokov 20. storočia pracoval americký informatik a profesor na MIT Joseph Weizenbaum na počítačovom programe, ktorý by sme mohli nazvať aj predchodcom súčasných chatbotov. Dal mu meno ELIZA podľa postavy z divadelnej hry Georgea Bernarda Shawa Pygmalion a jeho úlohou bolo simulovať rozhovor človeka s psychoterapeutom.

Chápanie ľudského jazyka a emócií bolo v systéme ELIZA veľmi obmedzené. No aj napriek tomu niektorí ľudia, ktorí spolupracovali s profesorom a interagovali s programom počas jeho vývoja a testovania, začali vnímať tento program ako osobu s vlastnými myšlienkami a pocitmi. Sám J. Weizenbaum bol prekvapený silnými emočnými reakciami, ktoré niektorí ľudia prejavovali pri interakcii s programom ELIZA. Tieto tendencie sa neskôr stali známe ako tzv. ELIZA efekt.

Imitácia hlasu

Zvykli sme si, že väčšina asistentov AI a podporných aplikácií má ľudské meno ako Alexa, Siri alebo Bixby. Používateľské rozhranie systémov AI, napríklad chatbotov, je zasa navrhnuté tak, aby napodobňovalo ľudskú konverzáciu aj s použitím emotikonov, slangového jazyka či neformálneho tónu. Niektoré systémy AI sú naprogramované takým spôsobom, aby vyjadrovali emócie, ako sú radosť, smútok alebo hnev, čím sa snažia vyvolať hlbšiu empatiu a pozitívnu používateľskú skúsenosť.

Aj táto snaha má však svoje hranice. Spoločnosť OpenAI čelila v tomto roku kritike pre jeden zo svojich hlasových modelov pre ChatGPT s názvom Sky, ktorý znel podobne ako hlas herečky Scarlett Johanssonovej. Model bol vytvorený bez jej súhlasu a vyvolal obavy zo zneužitia umelej inteligencie na šírenie dezinformácií či napodobňovanie identity. Herečka vyjadrila znepokojenie nad vzniknutou situáciou a zdôraznila potrebu zodpovedného a etického prístupu k AI.

Silná väzba

Snaha vytvárať asistentov, ktorí sa budú správať ako ľudia napríklad tým, že budú používať známe hlasy alebo simulovať ľudské emócie, sa môže zdať nevinná. Jej vplyv však môže byť významný predovšetkým vo vzťahu k najviac ohrozeným skupinám, ako sú deti, starší ľudia alebo ľudia odkázaní na pomoc druhých. Podľa výskumu publikovaného minulý rok takmer 30 % detí vo veku 11 rokov vyhlásilo, že virtuálna asistentka Alexa môže mať city, alebo viac ako pätina detí vo veku 8 rokov bola presvedčená, že sa takýto asistent AI môže cítiť odstrčený, ak sa s ním nerozprávame.

Silná väzba na systém AI môže viesť aj k tragickým dôsledkom. V roku 2023 v Belgicku spáchal samovraždu mladý muž. V prípade jeho smrti zrejme zohrala určitú úlohu aj fixácia na rozhovory, ktoré viedol s chatbotom. V tých, ktoré sa zachovali, sa zdôveroval so svojimi obavami o globálnej klimatickej zmene, pričom hľadal útechu práve v rozhovoroch s chatbotom, čo viedlo až k spomínanému nešťastnému koncu.

Intímne vzťahy

Existujú už aj asistenti AI, ktorí sú zostrojení tak, aby simulovali konverzáciu s ľudským partnerom, a to aj na veľmi intímnej úrovni. Tieto chatboty-partneri sa dokážu učiť z konverzácií s používateľmi a prispôsobovať sa ich individuálnym potrebám, vďaka čomu môžu pôsobiť autentickým dojmom. Existujú zdokumentované prípady, keď sa ľudia stali emocionálne závislými od takýchto chatbotov a vyvinuli si k nim silné citové väzby. Niektorí používatelia dokonca tvrdia, že sa do svojich chatbotov zamilovali, prežívali s nimi rozchody a trpeli emocionálnym trápením v dôsledku týchto interakcií.

Spoločnosť Luka, Inc., ktorá vyvinula chatbot s názvom Replika, zaviedla v roku 2022 zmenu obmedzujúcu v aplikácii erotické konverzácie a sexuálny obsah. Toto rozhodnutie vyvolalo kontroverzie a malo značný vplyv na používateľov, pretože to okrem iného zmenilo spôsob, ako chatbot generoval konverzáciu. Niektorí to vnímali ako radikálny zásah do svojho intímneho vzťahu s chatbotom opisujúc svoje prežívanie v duchu, akoby ich virtuálny partner zomrel.

Užitočný nástroj

Antropomorfizácia má v ľudskej komunikácii a myslení aj svoje pozitívne funkcie. Uľahčuje nám pochopenie sveta okolo nás tým, že mu dáva ľudský rozmer a robí ho tak známejším a prístupnejším. Takisto môže uľahčiť interakciu s umelými a na prvý pohľad neprístupnými systémami. Napríklad keď hovoríme, že umelá inteligencia sa učí z dát, premieňame abstraktný koncept na niečo, čo si vieme predstaviť a s čím sa vieme ľahšie stotožniť. Keď vnímame AI ako priateľa, s ktorým sa rozprávame, alebo keď si predstavujeme, že nám rozumie, umožňuje nám to s ňou nadviazať hlbšie a za istých okolností užitočné spojenie.

Dôležité je zbaviť sa nerealistických očakávaní, že nám úplne dokáže nahradiť kontakt so živým človekom. Keďže AI ním nie je, nemôžeme od nej ani očakávať, že bude mať rovnaké emócie, morálku alebo chápanie sveta ako my alebo že bude môcť byť zodpovedná za to, akým spôsobom funguje. Tejto téme sa náš tím venuje aj v rámci výskumného projektu TECHNE, v ktorom sa usilujeme o zmapovanie problémov zodpovednosti vznikajúcich pri interakciách človeka s umelou inteligenciou. Antropomorfizácia AI má aj svoje svetlé stránky, no sme to my ľudia, kto by mal niesť zodpovednosť za svoje činy.

Štefan Oreško, Juraj Podroužek

Kempelenov inštitút inteligentných technológií