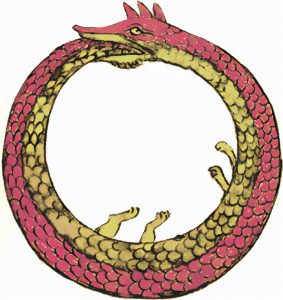

Uroboros, plaz, ktorý od chvosta požiera samého seba, býva považovaný za symbol večného cyklu života, smrti a znovuzrodenia. Pre veľké technologické spoločnosti vyvíjajúce modely generatívnej umelej inteligencie však môže takýto obraz symbolizovať nevyhnutnosť úpadku.

V spôsobe, akým sú modely umelej inteligencie trénované, sa môže skrývať zárodok ich skazy. Technologické spoločnosti sa v úsilí čo najviac na AI zarobiť snažia čo najviac obchádzať autorské práva ľudských tvorcov obsahu internetu. Lenže modely AI sú od ľudských tvorcov životne závislé. Odborníci varujú, že keď umelá inteligencia ovládne internet, začne požierať samu seba. Ako Uroboros – lenže znovuzrodenie v tom nebude.

Teória kolapsu

Či už je to Microsoft Copilot, alebo ChatGPT, všetky veľké jazykové modely (LLM) umelej inteligencie sú trénované na údajoch získaných z internetu. Môžu to byť články z novín alebo umelecké diela od nezávislých tvorcov a vzťahujú sa na ne autorské práva – bez ľudských tvorcov je umelá inteligencia ničím. Treba sa spýtať, či si OpenAI, Microsoft, Google a ďalší šíritelia týchto modelov AI túto skutočnosť naozaj uvedomujú. Tým, že Microsoft a jeho konkurenti nepoložili funkčné základy symbiotického vzťahu medzi tvorbou obsahu, správou a trénovaním LLM, možno neúmyselne odsúdili svoje vlastné modely hneď na začiatku.

Teória kolapsu modelu LLM opisuje hrozbu degeneratívneho procesu, ktorý môže nastať pri veľkých jazykových modeloch, ako je ChatGPT, keď sú trénované na bezcenných údajoch vytvorených samotnou umelou inteligenciou. Nástroje ako ChatGPT a Copilot totiž uľahčujú zaplavenie internetu zle napísanými, halucináciami naplnenými odpadovými údajmi, ktoré budú mať spätne kumulatívny a stupňujúci sa degeneratívny účinok na kvalitu výstupu LLM.

Keď AI halucinuje

Keď má model AI halucinácie, generuje informácie, ktoré sú nepravdivé, zavádzajúce alebo nezmyselné, no prezentuje ich, akoby boli pravdivé. Halucinácie sú bežné najmä vo veľkých jazykových modeloch (LLM), ako sú OpenAI GPT-4, Google Bard a ďalšie generatívne nástroje umelej inteligencie.

Najbežnejším dôvodom halucinácií sú skreslenia obsiahnuté v samotných údajoch, na ktorých bol daný model AI trénovaný. Ak sú údaje neúplné, zastarané alebo skreslené, model môže generovať nepresné výstupy. Niekedy sa model naučí podrobnosti v trénovacích údajoch do takej miery, že to negatívne ovplyvní jeho výkon na nových údajoch. Model generuje halucinácie, pretože aplikuje irelevantné vzorce. Modely AI môžu halucinovať aj vtedy, keď nemajú dostatočný kontext alebo keď je zadanie nejasné či protirečivé. K halucináciám môžu prispieť aj nesprávna architektúra a dizajn samotného modelu.

Zlé preklady zlých údajov

Priemerná skúsenosť s internetovým vyhľadávaním môže byť frustrujúca – priveľa výsledkov vyhľadávania upozornení na súbory cookie a SEO. Optimalizácia internetových stránok pre vyhľadávače (SEO) sú postupy, vďaka ktorým stránky zaujímajú viditeľnejšie miesto vo výsledkoch vyhľadávania bez ohľadu na obsah. Nástroje ako ChatGPT tento proces zjednodušujú tým, že poskytujú okamžité odpovede bez potreby preosievať informácie. To by mohlo podnietiť spoločnosti ako Microsoft a Google, aby do svojich vyhľadávacích služieb integrovali generatívnu umelú inteligenciu.

Podľa novej štúdie vedcov z Cornellovej univerzity môže byť v súčasnosti už 57 % obsahu na internete vytvorených umelou inteligenciou. Obsah na webe sa často prekladá do viacerých jazykov a nízka kvalita týchto viacsmerných prekladov naznačuje, že boli pravdepodobne vytvorené pomocou strojového prekladu, uvádzajú autori štúdie. Podľa nich sú namieste obavy: modely majú problém rozlíšiť originálne skúsenosti z prvej ruky, ktoré vytvoril človek, od falošných skúseností vygenerovaných umelou inteligenciou, čo môže viesť k poklesu kvality obsahu, na ktorom sú trénované. Už teraz sú obrovské množstvá písaného obsahu na internete generovaného AI plné chýb, nepresností a občas aj škodlivých lží.

R

Článok vznikol v spolupráci s magazínom NEXTECH.