V piatej časti seriálu o vysvetliteľnej umelej inteligencii si objasníme, ako meriame kvalitu vysvetlenia predpovede umelej inteligencie.

V predchádzajúcom článku sme si priblížili, aké komponenty a vlastnosti by mali mať dobré vysvetlenia rozhodnutí a správania sa modelov strojového učenia a umelej inteligencie (AI). Prvý komponent, zrozumiteľnosť, sa zameriava na to, do akej miery sú tieto vysvetlenia zrozumiteľné pre človeka. Druhý komponent, vernosť, hovorí o tom, či opisujú skutočné správanie modelu alebo celého systému.

Naplnenie žiaducich vlastností

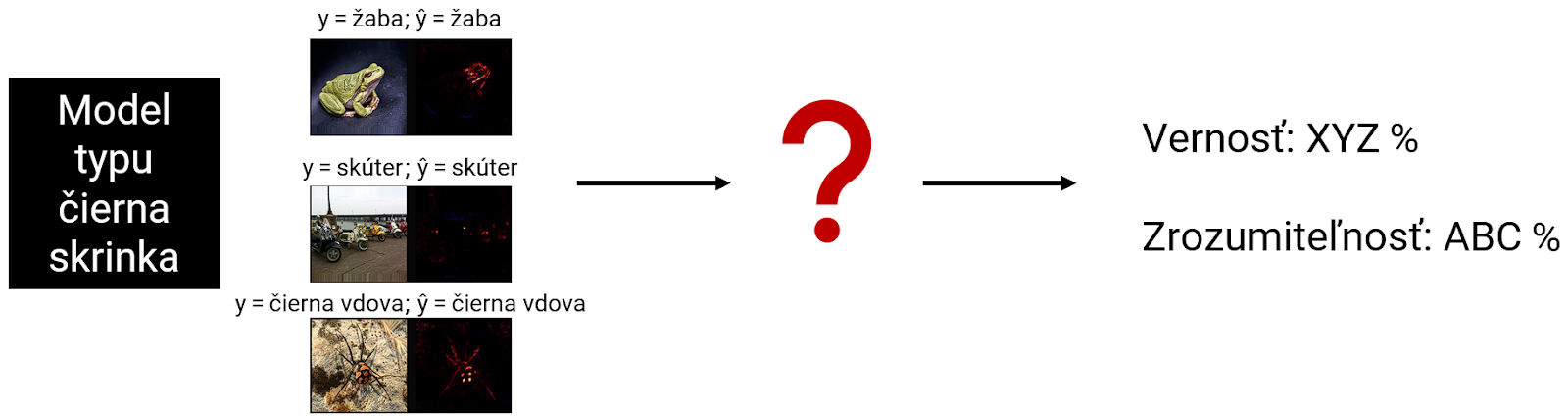

Zadefinovanie toho, aké vlastnosti by malo mať dobré vysvetlenie, je prvým krokom k tomu, aby sme ich dosiahli. Na vstupe máme model strojového učenia alebo AI (napr. neurónovú sieť), vstup (napr. obrázok), predpoveď, ktorú pre tento vstup model predpovedal, a napokon vysvetlenie. Na výstupe chceme určiť, ako zrozumiteľné a verné toto vysvetlenie je.

Metódy na vyhodnocovanie kvality vysvetlení môžeme rozdeliť do dvoch skupín: vyhodnocovanie zamerané na človeka a vyhodnocovanie zamerané na funkcionalitu. Pri prvej skupine vychádzame z predpokladu, že adresátom vysvetlení je človek, a preto je potrebné do procesu vyhodnocovania zapojiť ľudí. Pri druhej skupine je zasa cieľom kvantitatívne a automatizované vyhodnotenie kvality vysvetlení.

Vyhodnocovanie zamerané na človeka

Pri vyhodnocovaní kvality vysvetlení zameranom na človeka je hlavná myšlienka jednoduchá – na vyhodnotenie ich kvality použiť ľudí, ktorým sú vysvetlenia adresované. Pozeráme sa pritom na dva aspekty – ako vysvetlenia pomáhajú ľuďom plniť rôzne úlohy a ako ľudia vnímajú vysvetlenia a ich prínos pre nich samotných. Vo svojej práci z roku 2021 J. Zhou spolu s kolegami hovoria o vyhodnocovaní založenom na aplikácii (angl. application-grounded) a vyhodnocovaní založenom na ľuďoch (angl. human-grounded).

Z pohľadu vyhodnocovania založeného na aplikácii nás zaujíma, ako veľmi a či vôbec dokážu vysvetlenia pomôcť používateľom pri plnení rôznych úloh. Zväčša porovnávame rôzne parametre výkonnosti, efektívnosti či komfortu dvoch skupín používateľov, ktorí plnia tú istú úlohu – napríklad používatelia zo skupiny A majú k dispozícii iba predpoveď modelu, používatelia zo skupiny B aj nejakú formu vysvetlenia.

Zefektívnenie práce administrátora

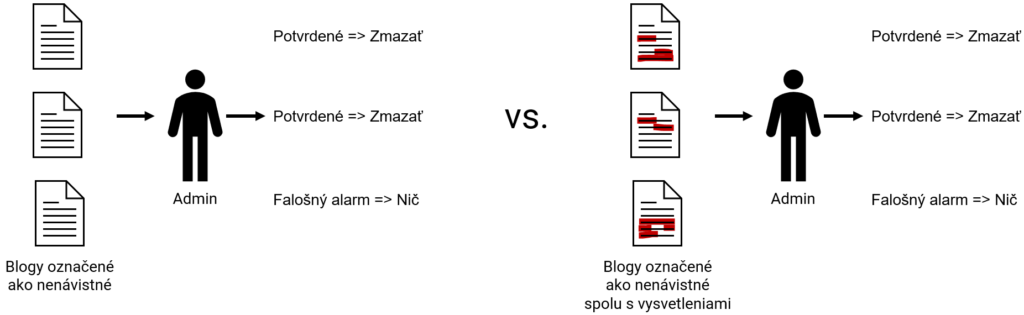

Pozrime sa na jednoduchý príklad – blogovaciu platformu. Jednou z úloh jej administrátora je identifikovať a prípadne mazať nenávistné príspevky, ktoré sa na platforme vyskytnú. Ak ide o blog, na ktorý denne pribudnú desiatky alebo stovky tisíc príspevkov, nie je v silách jedného a potenciálne ani viacerých administrátorov skontrolovať ich všetky. Prirodzeným riešením je využiť detektor nenávistných prejavov založený na strojovom spracovaní prirodzeného jazyka, ktorý identifikuje potenciálne nenávistné príspevky. Počet príspevkov, ktoré musí administrátor skontrolovať, sa tak prudko zníži. Naďalej ich však môžu byť tisícky denne. Akým spôsobom vie vysvetliteľná AI pomôcť ešte viac zefektívniť prácu administrátora?

Porovnajme si tieto dve situácie. V prvej situácii má administrátor k dispozícii iba samotné príspevky, ktoré umelá inteligencia identifikovala ako nenávistné. V druhej sú v textoch príspevkov zvýraznené tie časti, ktoré AI presvedčili, že ide o nenávistné príspevky. Keďže administrátor nemôže len tak zmazať príspevok, ktorý neporušil pravidlá blogu (platí sloboda slova), musí príspevky identifikované AI overiť. V prvom prípade musí skontrolovať celý text, až kým nenarazí na nenávistný prejav (potvrdený nenávistný prejav), alebo kým prečíta celý text a usúdi, že ide o falošný poplach a príspevok je v poriadku. V druhom prípade, keď má administrátor k dispozícii aj vysvetlenia, sa zameria na zvýraznené časti textov, čo môže významne zefektívniť jeho prácu, a to najmä ak ide o skutočne nenávistný príspevok. V tom prípade stačí, aby sa napríklad v texte rasistický alebo antisemitský výrok vyskytol raz. Vďaka tomu sa administrátor nemusí ďalej zaoberať zvyškom textu a rovno môže príspevok skryť, zmazať alebo vyzvať autora na korekciu. Týmto sa významne uľahčí a zrýchli práca administrátora.

Kvantitatívne a kvalitatívne vyhodnocovanie

Spôsob kvantitatívneho merania kvality vysvetlení závisí od úlohy. Iným spôsobom budeme merať výkonnosť používateľov systému určeného na detekciu nenávistných príspevkov a iným používateľov systému na počítanie rakovinových buniek v histologických snímkach. V príklade s blogovacou platformou by bolo vhodné merať napríklad rozdiely: v počte príspevkov (efektívnosť), ktoré sú schopní skontrolovať administrátori majúci a nemajúci k dispozícii vysvetlenie, v presnosti, ktorú dosiahnu administrátori z jednej alebo druhej skupiny či v schopnosti odhaliť nesprávnu predpoveď modelu.

Veľkou výhodou kvantitatívneho merania je jeho objektívnosť. Pri správne nastavenom experimente (vyvážené skupiny používateľov, rovnaké podmienky atď.) dokážeme s veľkou istotou povedať, či a aký veľký prínos mali poskytnuté vysvetlenia.

Pri kvalitatívnom meraní sa viac zameriavame na subjektívne hodnotenie prínosu a spokojnosti používateľov s vysvetleniami. Častou formou získavania spätnej väzby sú dotazníky, v ktorých používatelia hodnotia vysvetlenia z rôznych uhlov pohľadu, napríklad užitočnosti, spokojnosti, zrozumiteľnosti, istoty a dôvery.

Napriek tomu, že kvalitatívne meranie je do veľkej miery subjektívne, ide o dôležitú súčasť vyhodnocovania metód vysvetliteľnosti. Sú to totiž používatelia (ľudia), komu sú vysvetlenia určené, a preto je nutné merať aj ich subjektívny postoj k nim. Keby napríklad vysvetlenie pomohlo používateľovi dosiahnuť väčšiu presnosť pri plnení úlohy, no bol by z neho frustrovaný, pretože by bolo príliš rozsiahle, nebolo by to optimálne.

Menej je viac

Výhodou vyhodnocovania zameraného na človeka je, že prostredníctvom neho dokážeme zmerať, aký benefit z vysvetlení majú používatelia – do akej miery sú s vysvetleniami spokojní a ako im pomáhajú pri plnení rôznych úloh. Vďaka tomu môžeme používateľovi poskytnúť vysvetlenie šité na mieru a v dostatočnej miere napĺňajúce vlastnosti, ktoré by dobré vysvetlenie malo mať (pozri Quark 3/2023).

V minuloročnej práci R. Tompkinsa a jeho spolupracovníkov zverejnenej na workshope o vysvetliteľnej umelej inteligencii na konferencii IJCAI sa ukázalo, aké dôležité je overovať rôzne formy a obmeny vysvetlení, ktoré dostane používateľ k dispozícii. Napríklad sa môže zdať, že čím je vysvetlenie rozsiahlejšie a kompletnejšie, tým viac by malo človeku pomôcť pri plnení danej úlohy. Pri jednom z experimentov s 208 účastníkmi autori porovnávali, aké výsledky dosiahnu účastníci, ktorým poskytnú rôzne počty tzv. counterfactual (protichodných) vysvetlení. Ukázalo sa, že menej rozsiahle vysvetlenie (1 alebo 2 counterfactuals) bolo pre používateľov prínosnejšie. Okrem toho aj používatelia vyjadrili preferenciu dostávať menej vysvetlení.

Nevýhody

Potenciálnou nevýhodou vyhodnocovania zameraného na človeka je subjektivita a s tým spojená citlivosť vyhodnocovania a jeho výsledkov na výber ľudí, ktorí sú do neho zapojení. V prípade, že chceme do experimentu zapojiť väčší počet ľudí, môže byť problém nájsť dostatočne veľa rozmanitých koncových používateľov. Napríklad množstvo rádiológov, s ktorými by sme chceli testovať prínos vysvetlení v diagnostickom softvéri podporovanom AI, je veľmi obmedzené a ich čas vzácny. Preto sme často odkázaní na vyhodnocovanie s menšou vzorkou koncových používateľov alebo na testovanie s laikmi.

Pri tomto type vyhodnocovania sme schopní priamo merať zrozumiteľnosť vysvetlení (je to jedna z otázok, ktorú môžeme používateľovi položiť v dotazníku), no vernosť vieme merať iba nepriamo. Vychádzame totiž z predpokladu, že model je príliš komplexný na to, aby človek úplne pochopil jeho vnútorné správanie sa spôsob, akým dospel k predpovedi. Nevie teda ani povedať, či vysvetlenie korešponduje so skutočným správaním sa modelu.

Ďalším problémom je náročnosť takéhoto vyhodnocovania na čas a zdroje. Súčasný výskum vo vysvetliteľnej AI neustále prináša nové prístupy a metódy. Zároveň platí, že vysvetlenie by malo byť šité na mieru danej úlohe a modelu (a dátam). Keby sme však chceli vyhodnotiť, ktorá z mnohých metód vysvetliteľnosti a ich rôznych kombinácií najviac pomôže používateľovi pri riešení danej úlohy a používateľ ju bude považovať za najlepšiu, museli by sme pre každú úlohu vykonať veľké množstvo experimentov s ľuďmi, čo nie je uskutočniteľné.

Odpoveď na problém škálovania, subjektivitu a absenciu priameho merania vernosti vysvetlení prináša vyhodnocovanie kvality vysvetlení zamerané na funkcionalitu.

Text a schémy Martin Tamajka

Kempelenov inštitút inteligentných technológií

Tento článok je súčasťou série Vysvetliteľná umelá inteligencia: od čiernych skriniek k transparentným modelom.

Projekt podporila Nadácia Pontis.

Anglickú verziu článku si môžete prečítať tu.