Filtrovanie prejavov nenávisti na internetových fórach patrilo vždy k takmer nesplniteľným úlohám administrátorov a moderátorov diskusií. Keby to namiesto ľudí dokázala umelá inteligencia, mohlo by to priniesť výrazný pokrok v čistení verejného priestoru od toxickej negativity, ktorá ničí slobodnú výmenu názorov.

Výhody zapojenia umelej inteligencie (UI) do moderovania diskusií na internete sú zrejmé. Umelá inteligencia sa neunaví a nepociťuje nudu. Nič dôležité jej neujde iba preto, lebo by jej po nekonečnom opakovaní rovnakého úkonu klesala pozornosť. Človek však dokáže vidieť veci v kontexte a nerozhoduje sa iba na základe formálnych znakov.

Hlboké učenie

Nenávistné prejavy (tzv. hate speech) dokážu celkom znehodnotiť komunikáciu na sociálnych sieťach či stránkach médií, firiem a rôznych inštitúcií. Takéto prejavy na sociálnych sieťach sa množia, čo podľa globálneho združenia odborníkov z oblasti technológií IEEE odrádza ľudí od účasti na nich a zároveň vytvára toxické prostredie pre tých, ktorí zostávajú online. Ako v magazíne IEEE Spectrum vo februári tohto roku upozornil Tarique Anwar z Katedry informatiky University of York vo Veľkej Británii, súčasné postupy platforiem sociálnych médií na úpravu obsahu to nedokážu kontrolovať. A nenávistné prejavy online sa niekedy prejavujú aj v reálnom prostredí, čo vedie k trestnej činnosti a násiliu, uviedol T. Anwar.

Na odhaľovanie nenávistných prejavov na sociálnych médiách bolo vyvinutých mnoho rôznych modelov umelej inteligencie, ešte vždy je však náročné vyvinúť také modely, ktoré by boli výpočtovo efektívne a dokázali zohľadniť kontext príspevku, čiže určiť, či príspevok skutočne obsahuje nenávistný prejav alebo nie. T. Anwar sa podieľal na vývoji nového modelu umelej inteligencie s názvom BiCapsHate, ktorý by mohol obe tieto prekážky prekonávať. Model, ktorý britskí výskumníci predstavili v januári tohto roku, je podľa svojich autorov v porovnaní s inými umelými inteligenciami detegujúcimi nenávistné prejavy v niekoľkých ohľadoch jedinečný. BiCapsHate pozostáva z niekoľkých pokročilých vrstiev hlbokých neurónových sietí, z ktorých každá sa venuje zachytávaniu rôznych vlastností nenávistných prejavov. Model obsahuje vrstvu hlbokého učenia, ktorá prekladá jazyk príspevku na sociálnej sieti na číselnú hodnotu a vyhodnocuje túto postupnosť dopredu aj dozadu. Týmto spôsobom je umelá inteligencia schopná pochopiť kontext, ktorý sa skrýva za príspevkom na sociálnych médiách, a lepšie určiť, či je príspevok nenávistný alebo nie.

Hľadanie kontextu

Podobne k problému kontextu jazykových prejavov pristupujú niektoré už existujúce modely umelej inteligencie, napríklad HateBERT, ToxicBERT a fBERT. Do určitej miery dokážu úspešne postihnúť kontext nenávistných prejavov, ich práca sa však stretáva s ťažkosťami, pretože jazyk môže byť viacznačný. Podľa internetovej stránky spoločnosti deepsense.ai, ktorá sa zaoberá využitím umelej inteligencie v rôznych oblastiach, je preto pri vytváraní dobrého detektora nenávistných prejavov na báze strojového učenia prvou úlohou vytvoriť a označiť súbor údajov.

Vzhľadom na to, že rozdiely medzi nenávistnými prejavmi a prejavmi, ktoré nie sú prejavmi nenávisti, sú kontextuálne, zostavenie definície a správa súboru údajov je veľkou výzvou. Kontext prejavu môže závisieť napríklad od kontextu diskusie (historické texty môžu byť automaticky, no falošne klasifikované ako nenávistné prejavy), spôsobu použitia jazyka (nenávistné prejavy použité na umelecké účely), vzťahu hovoriaceho k cieľovej skupine (napríklad členovia nenávidenej skupiny majú pri používaní nevhodného jazyka na adresu iných členov tejto skupiny viac slobody ako tí, ktorí nie sú jej súčasťou), ďalším problémom pri rozpoznávaní kontextu môžu byť irónia a sarkazmus a pod.

Prostriedkom na hodnotenie presnosti systémov umelej inteligencie je tzv. f-skóre. Autori BiCapsHate uvádzajú, že ich model dosiahol f-skóre 94 a 92 % na vyvážených a nevyvážených súboroch údajov, čo by znamenalo, že je skutočne presnejší ako všetky doterajšie. Ďalšou výhodou podľa nich je, že model dokáže pracovať pri splnení nižších hardvérových nárokov. Zatiaľ čo iné modely si na výpočty vyžadujú špičkové hardvérové prostriedky, BiCapsHate sa dá podľa T. Anwara vykonávať na CPU aj s iba 8 gigabajtmi RAM. Nevýhodou je, že umelá inteligencia bola zatiaľ vyvinutá a testovaná na analýzu nenávistných prejavov len v angličtine, takže by ju bolo potrebné prispôsobiť pre iné jazyky, dodal magazín IEEE Spectrum.

V slovenčine a češtine

Zdá sa, že jazyková bariéra UI pri odhaľovaní nenávistných prejavov na sociálnych sieťach už bola prekonaná. Slovenská technologická spoločnosť TrollWall v júni oznámila, že vyvinula vlastné softvérové riešenie na skrývanie nenávistných komentárov na báze umelej inteligencie. Nástroj už funguje na platformách Facebook a Instagram, pričom jeho jazykový model rozumie slovenčine a češtine. Postupne pribúdajú nové funkcionality a jazyky a rozširujú sa aj možnosti moderovania diskusií v online priestore. TrollWall používajú pri správe sociálnych sietí napríklad v kancelárii českého prezidenta, ale aj niektoré médiá či mimovládne a neziskové organizácie.

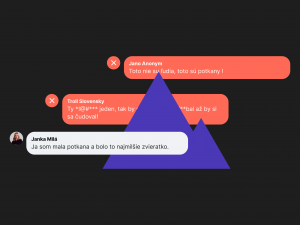

TrollWall má svoj vlastný model neurónovej siete, ktorý je schopný pomáhať moderovať diskusie vo virtuálnom priestore. Umelá inteligencia dokáže rozpoznať a automaticky skryť komentáre, ktoré vyhodnotí ako vulgárne alebo nenávistné. Tým chráni reputáciu majiteľov profilov na sociálnych sieťach, ale najmä samotných používateľov pred toxickým vplyvom nenávistnej diskusie a prispieva k tvorbe bezpečnejšieho online prostredia. Model bol natrénovaný na analýze viac ako štvrť milióna komentárov zo sociálnych médií. Umelá inteligencia sa naučila rozpoznávať a detegovať nenávistný a vulgárny obsah nielen podľa kľúčových slov, ale aj z kontextu. TrollWall dokáže rozpoznať nielen známe nadávky a ich variácie, ale aj kontextuálny hejt. Napríklad spojenie ty si potkan označí za hejt, kým uhryzol ma potkan nie, uviedol Pavol Bujňák, šéf technológií spoločnosti TrollWall.

Dôležité je, že ľudský faktor úplne nezmizol. Administrátor má plnú kontrolu nad obsahom a jednoducho môže odkryť akýkoľvek komentár, ktorý predtým umelá inteligencia vyhodnotila ako problematický. Vďaka schopnosti identifikovať a automaticky skrývať príspevky, ktoré sú vulgárne alebo obsahujú nenávistné prejavy, však TrollWall znižuje množstvo obsahu, ktorý musia manuálne kontrolovať moderátori alebo administrátori stránok na sociálnych sieťach.

V reálnom čase

TrollWall reaguje na problémový obsah takmer okamžite. Najťažšie je ustrážiť diskusiu na profiloch, ktoré generujú veľký počet komentárov. Naša technológia vie reagovať v priebehu sekúnd a zabráni tomu, aby sa nenávistné komentáre presadili a boli viditeľné na popredných pozíciách, uviedol CEO TrollWall Tomáš Halász. Podľa neho bude softvér v budúcnosti schopný vykonávať aj ďalšie pokročilejšie funkcie. Chceme byť schopní pomáhať komunitným manažérom rýchlejšie reagovať, napríklad navrhovaním odpovedí na časté otázky na základe vlastných podkladov. Posvietiť si chceme aj na dezinformácie a hoaxy.

Umelá inteligencia už skontrolovala na slovenskom Facebooku viac ako 2 milióny komentárov a skryla pritom vyše 300-tisíc hejtov (nenávistných prejavov). V posledných rokoch zažívame nárast nenávistných prejavov v online priestore. Analýza ukázala, že až 15,47 % zo vzorky viac ako 500-tisíc komentárov bolo vulgárnych alebo nieslo znaky nenávistného prejavu. Sme presvedčení, že ich filtrovaním dávame viac priestoru slušnej a konštruktívnej debate, uviedol Dávid Benedig, šéf digitálu v komunikačnej a PR agentúre Seesame, ktorá tiež používa TrollWall pri správe profilov svojich klientov.

R